Hoy te hablaremos de un truco SEO que te permitirá tomar ventaja de un elemento que ya está en tu web, pero que no siempre sabemos cómo editar y optimizar. ¡Sigue leyendo esta guía de robots.tx en WordPress!

¿Qué es el archivo robots.txt en WordPress?

El archivo robots.txt también llamado estándar de exclusión de robots, protocolo de la exclusión de robots, es un archivo de texto que le dice a los robots de los motores de búsqueda que páginas de tu sitio debe rastrear y cuáles no.

Este archivo contiene directivas para los buscadores, consiste en una o más reglas.

El archivo robots txt WordPress pertenece a la raíz de tu sitio, por eso debe ser https://www.jesuslopezseo.com/robots.txt, es un texto plano.

¿Cuál es su función?

Se utiliza para manejar cómo los rastreadores acceden a tu web. Puedes utilizar las directivas para evitar que rastreen partes específicas de tu web y darle a los motores de búsqueda consejos sobre cómo rastrearla.

Su función es muy importante para el SEO, aunque los motores de búsqueda suelen respetar las directivas del robots.txt, no siempre evita que las páginas de tu sitio aparezcan en el SERP.

El archivo robots.txt se debería utilizar para:

- Bloquear páginas no públicas: por ejemplo, páginas de inicio de sesión o de resultados de búsquedas internas, que no quieres que se indexen. Incluso páginas con contenido duplicado.

- Permitir la indexación de recursos: el robots.txt se debe utilizar para permitir el rastreo de imágenes, vídeos y audios, al igual qe los js, css. Pero también puede servir para bloquear el rastreo de otros que no quieras que sean rastreados.

En resumen, la función del robots.txt es decirle a las arañas, bots o robots de los buscadores que no rastreen páginas específicas de tu web. Si no hay un archivo, entonces los bots no tendrán instrucciones de rastreo, directivas, y rastrearán todo tu sitio.

¿Por qué es importante para el SEO?

Aunque no te hayas dado cuenta, probablemente tu web tiene muchas páginas. Google tiene un «presupuesto de rastreo» para los sitios web, que implica la cantidad de URL que puede rastrear. Este afecta principalmente a los sitios que tienen miles de URL. Por eso es fundamental darle prioridad al contenido que quieres que Google rastree.

Google también tiene un límite en la frecuencia de rastreo que, como su nombre lo indica, limita la frecuencia con la que visitan el sitio. Esta frecuencia varía según el estado de rastreo y el límite que fijas en Search Console. Otro factor es la demanda de rastreo, que varía según la popularidad de tu URL y la inactividad.

Como dueño de sitio web querrás que Google emplee el presupuesto de rastreo de la mejor forma posible; es decir, rastreando las páginas que son más importantes.

Por lo que, si creas un buen archivo robots.txt le dices a los robots de los motores de búsqueda que eviten ciertas páginas y rastreen solo las que tienen el contenido más útil. Entonces, el bot rastreará e indexará ese contenido. Conseguirás un rastreo más eficiente.

¿Cómo editar el archivo robots txt en WordPress?

Al hacer SEO para WordPress debes saber optimizar este archivo siguiendo las mejores prácticas:

Edición manual del archivo robots.txt: directivas

El archivo de robots txt WordPress es de texto, puedes crearlo con Notepad, TextEdit, entre otros, el formato siempre es el mismo:

User-agent: X Disallow: Y

Donde User-agent es el bot específico al que le hablas. Y todo lo que sigue a disallow son páginas o secciones que quieres bloquear y allow las que permites. Por ejemplo:

User-agent: googlebot Disallow: /wp-content/*

Esta regla le dice al bot de Google que no indexe las URL que incluyan wp-content.

Podrías usar un comodín (*) en lugar del nombre del bot, para referirse a todos los robots. También puede usarse para referirse a todas las URL.

User-agent: * Disallow: /wp-content/*

La directiva Allow puede contrarrestar a la directiva Disallow. Se pueden usar en conjunto para decirle a los buscadores que accedan a un archivo específico o página dentro de un directorio que está con disallow. En este caso nunca uses el asterisco o comodín.

User-agent: * Disallow: / Allow: /public/

Una vez que hayas editado el archivo y lo tengas listo, es momento de subirlo a tu web, puedes hacerlo a través de tu compañía de hosting o con la ayuda de tu webmaster.

Uso de plugins para modificar el archivo robots.txt

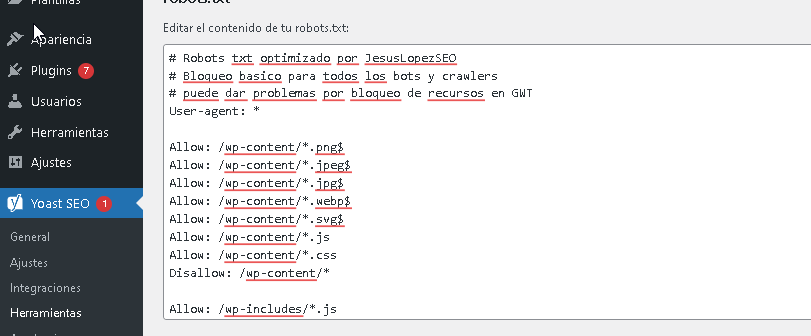

El plugin Yoast SEO tiene una herramienta de edición del archivo robots.txt. Accedes a través de Yoast SEO > Herramientas > Editor de archivos. Desde allí puedes crear o modificar el archivo robots.txt con directrices personalizadas.

Yoast SEO genera un archivo robots.txt básico, pero permite añadir reglas más complejas dependiendo de las necesidades del sitio.

All in One SEO también ofrece una funcionalidad similar para gestionar el archivo robots.txt.

Para acceder, ve a All in One SEO > Herramientas y selecciona la pestaña robots.txt. Desde allí, puedes añadir directrices para permitir o denegar el acceso a ciertas partes del sitio.

Buenas prácticas al editar robots.txt

- El archivo robots txt debe incluir siempre al final la dirección del mapa del sitio, así:

Sitemap: https://www.ejemplo.com/sitemap.xml

- Uno de los usos más prácticos del archivo robots txt es maximizar el presupuesto de rastreo de los motores de búsqueda, diciéndoles qué partes de tu web no deben rastrear, las que no muestras al público.

- Debes ingresar la parte de la url que va después del .com o .es, y entre barras. Por ejemplo, como mencionamos en el ejemplo anterior, debería ser Disallow: /wp-content/* y no Disallow: www.misitio.com/wp-content/*.

- Bloquea del rastreo páginas como contenido duplicado útil, páginas de agradecimiento.

- El archivo robots txt es sensible a mayúsculas y minúsculas, asegúrate de usar minúsculas en el nombre del archivo.

- Debes utilizar una línea para cada directiva, de lo contrario los buscadores podrían confundirse.

- Para indicar el final de una URL usa el símbolo de dólar ($) al final de la línea. Por ejemplo: Allow: /wp-content/*.jpeg$.

Errores comunes a evitar en la configuración

Es importante estar atento al momento de editar el robots.txt, ya que un pequeño error podría ocasionar que todo tu sitio se desindexe. En el siguiente apartado verás que Google puede mostrarte las incidencias en tu archivo, toma en cuenta eso para hacer las correcciones.

Recuerda que el archivo siempre debe estar en la raíz de tu sitio, nunca en un subdirectorio.

Además, si no eres cuidadoso con las directivas, puede ser que unas tengan conflicto con otras.

Tampoco creas que con el robots txt puedes controlar la indexación en los resultados. Usar noindex en este archivo es un error muy común. Con disallow puedes evitar el rastreo, pero no evitar que aparezca en los resultados.

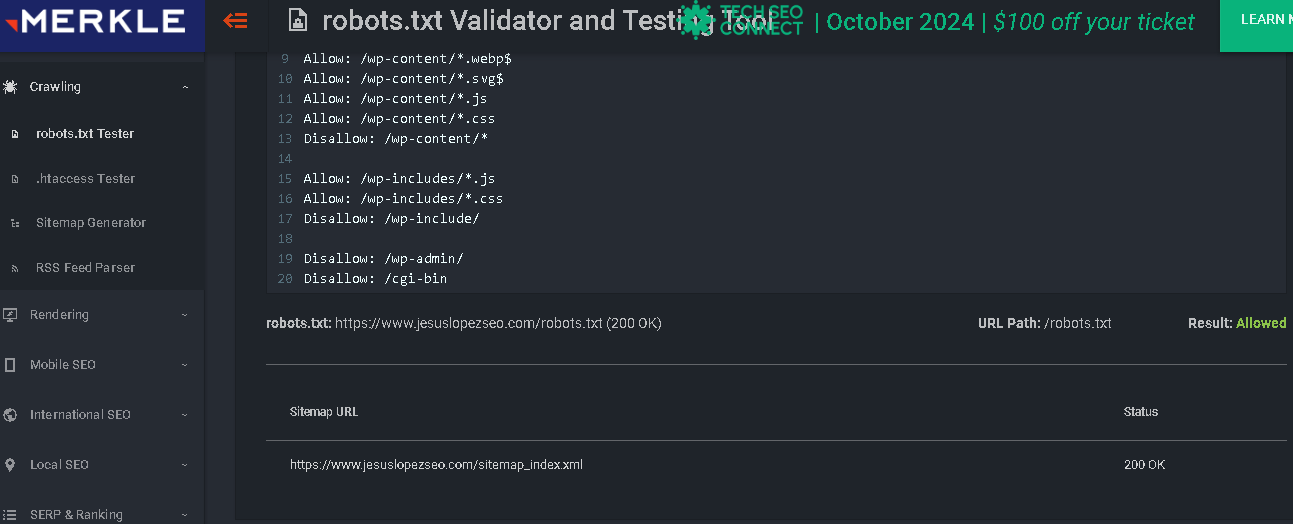

Nuestro archivo robots.txt está optimizado para WordPress, así que puedes usarlo en tu sitio. Visítalo https://www.jesuslopezseo.com/robots.txt haz clic a la derecha, Guardar como y ¡listo!

¿Cómo ver y mandar a Google los cambios en el archivo robots.txt?

Puedes revisar que el archivo está funcionando o es accesible públicamente si abres una ventana en Modo incógnito en tu navegador y colocas la URL https://www.ejemplo.com/robots.txt. Si ves el contenido, entonces puedes comprobarlo con las herramientas específicas.

Cuando esté todo listo, no tendrás que enviar tu archivo robots txt WordPress a Google, los bots lo rastrean automáticamente.

Puedes revisar cuántas páginas tienes indexadas en Google Search Console, también enviar cambios que hayas hecho en tu archivo. Si al verificar ves que el número de páginas que quieres que se indexen coinciden, entonces no tendrás que hacer cambios, pero si el número es más alto de lo que esperabas, es decir, hay más páginas indexando, entonces deberías actualizar el archivo.

En Search Console, Indexación -> Páginas te permite ver este número y te indica por qué hay páginas que no se indexan, una de las razones es Bloqueada por robots.txt.

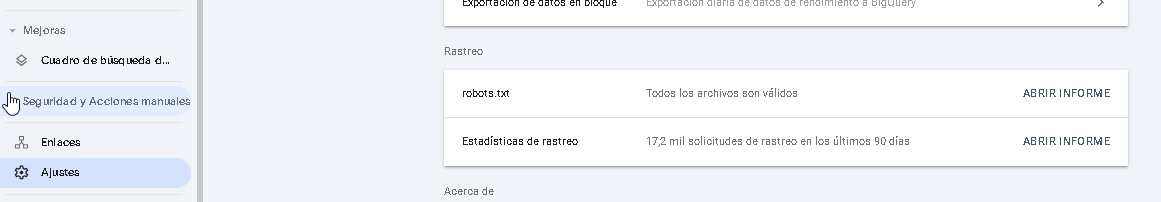

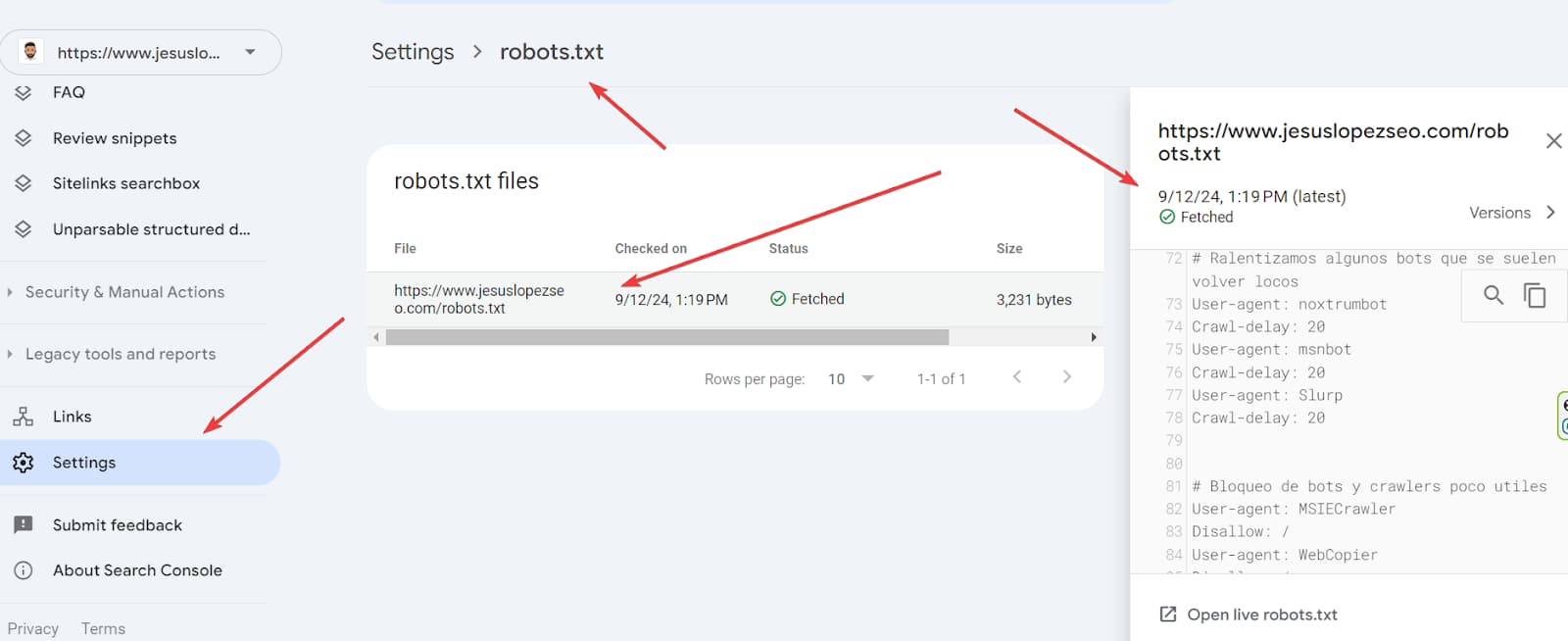

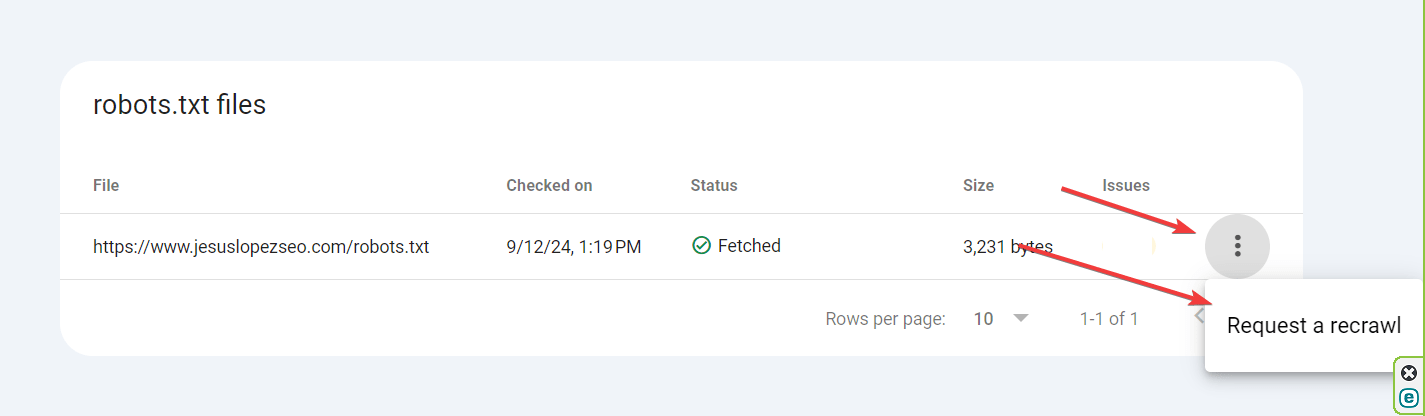

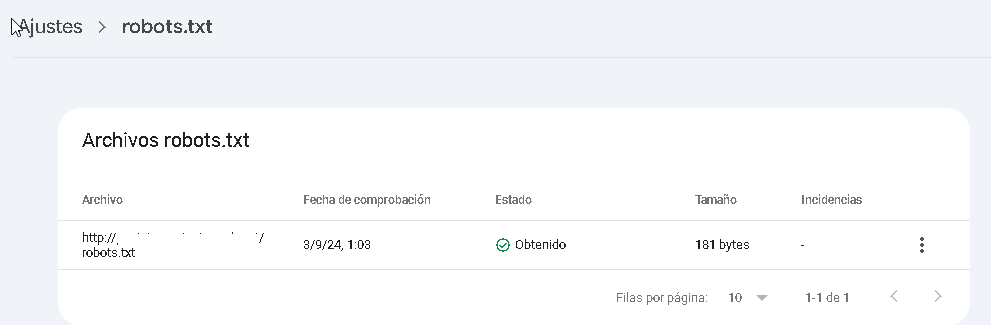

Por otro lado, en Ajustes -> ve a rastreo y haz clic en Abrir informe en robots.txt puedes confirmar el archivo.

Ahí podrás ver si tiene incidencias y cuáles son, así como la última fecha de comprobación. Haciendo clic sobre este verás una ventana desplegable con toda la información del rastreo y ver el texto al que accede Google. Este puedes descargarlo, será una copia real del archivo que rastrea Google.

Haciendo clic en los tres puntos que señalamos en la imagen abajo, puedes Solicitar un nuevo rastreo una vez que hayas hecho las actualizaciones necesarias en el archivo en tu web.

Herramienta gratis para chequear el robots.txt

- Technical SEO robots.txt Tester: es una herramienta que permite probar y validad tu archivo robots txt de Wortdpress. Revisar si una URL está bloqueada, su estado y el usuario agente. Además, puedes comprobar los recursos de la web como CSS, JavaScript e imágenes que estén disallowed (no permitidas).

- Google Search Console: accediendo a esta URL https://www.google.com/webmasters/tools/robots-testing-tool y seleccionando tu propiedad en Search Console puedes ver el estado de tu archivo. O ingresando directamente a Search Console -> Ajustes

Configuraciones avanzadas para robots.txt WordPress

En WordPress hay directivas específicas que debes aplicar en el robots txt, como:

- Bloquear el acceso a carpetas como /wp-admin/ o /login/, que contienen información sensible y no es relevante para el SEO. Ejemplo:

User-agent: * Disallow: /wp-admin/

- No deberían rastrear los resultados de búsqueda de páginas internas. Evitar que los motores de búsqueda indexen páginas que pueden generar contenido duplicado, como filtros de productos o páginas con parámetros de URL. Ejemplo:

User-agent: * Disallow: /search

- Tampoco quieres que rastreen las páginas de etiquetas.

- Debes bloquear la página de error 404.

- Optimizar el uso de recursos del servidor. Limitar el acceso de rastreadores a recursos pesados como imágenes de alta resolución o archivos que no aportan valor para el SEO. Por ejemplo:

User-agent: * Disallow: /large-files/

En general, el archivo robots.txt en WordPress es muy importante para el posicionamiento web, especialmente para los sitios web grandes, con muchas URL, ya que permite darle instrucciones claras a los bots sobre a qué contenido no deben acceder. Por eso es clave saber cómo editarlo y optimizarlo.

Periodista y redactora SEO, con más de 8 años de experiencia en creación de contenidos y SEO. Jefa de contenidos de Posicionamiento Web Systems.